展望2023-2028:AGI过去现在及未来发展

1 前言

2022年末,ChatGPT的“横空出世”让普通大众对于AI突破有了新的认识,人们第一次看到一个AI能够干各种各样需要常识甚至一定专业知识的事情,聊天,写论文,写代码都不在话下。ChatGPT的影响力不亚于当年的AlphaGo,我们谈论的AI由此在慢慢的变成AGI(通用人工智能)。在这之前,AGI一直是一个遥不可及的目标,之前人类所做的种种AI突破都是Narrow AI 弱人工智能,即一个AI只能干一种事,同时也都不具备所谓的常识。ChatGPT改变了这一点,让AGI开始走进现实,虽然现在还是比较弱的AGI。

AGI未来将如何发展,是一个非常值得探讨的话题。因此,本文尝试先分析AGI的发展史,然后抛出一些AGI未来发展的观点,希望对感兴趣的朋友们有所帮助。

PS:本文并未使用GPT参与写作。

2 2013-2022:AGI的简要发展史

要预知未来,先了解过去。AGI可以认为是DeepMind率先引入大众视野并通过其努力引发整个世界关注的AI终极方向。

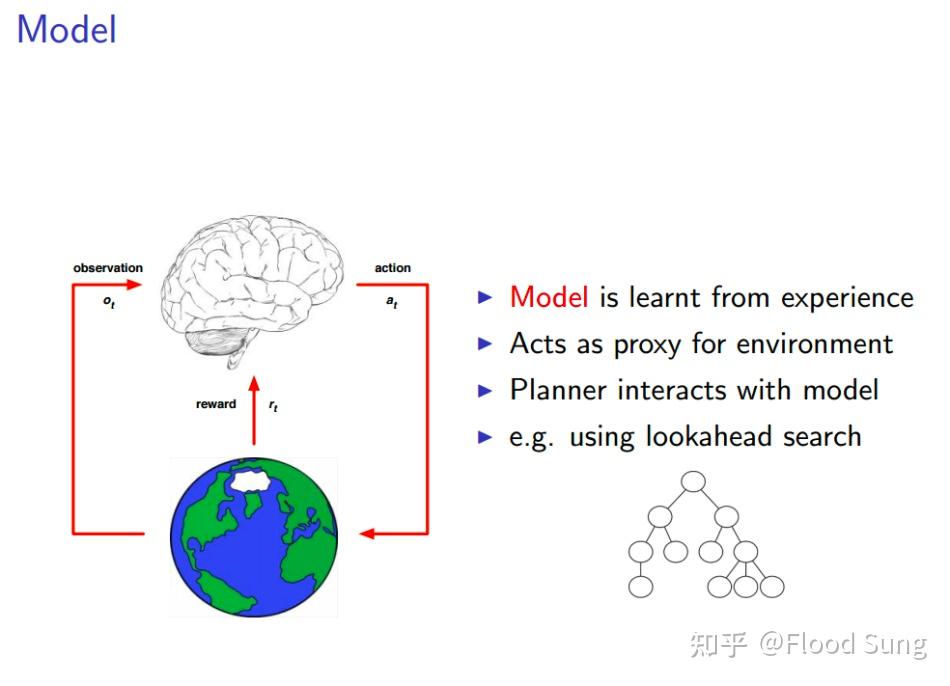

在当年David Silver的Reinforcement Learning课程中,我们看到了他提出的解决通用智能的算法范式,至今看来基本正确,只是需要再加一个要素来加速这个过程:Imitation Learning(IL) 模仿学习:

2013年:Deepmind发表了第一版的DQN,第一次将DL和RL结合,开启了AGI的实现道路。

2015年:Deepmind将DQN发表到了Nature,年底OpenAI成立:

2016年:DeepMind的AlphaGo横空出世,实现了深度学习的全新里程碑:

2018年:OpenAI 提出Dota Five,在Dota上战胜职业选手:

2019年:Deepmind提出AlphaStar,在星际争霸上战胜职业选手:

2019年:Openai实现了用机械手玩魔方:

接下来的里程碑就转向了语言模型,图文生成及AI for Science了

2019年:OpenAI发布GPT-2

2020年:OpenAI发布Image GPT

2020年:DeepMind发布AlphaFold 2

2021年:OpenAI发布Dalle, GPT 3, Codex

2022年:DeepMind发布AlphaCode

2022年:OpenAI 发布Dalle 2,InstructGPT,ChatGPT

上面列举的可能不全,主要就是OpenAI和DeepMind的工作。当然其他公司及学界也有很多不错的工作,但论影响力都达不到他们的高度。为什么就这两家?因为也就这两家宣称要搞AGI!

3 AGI发展的背后缘由

我们看到了这么多的里程碑,我们一定要问的问题是

这些里程碑之间有什么联系?

其实他们的联系在一开始David Silver的ppt里就说明了,接下来的这些发展都是在这个范式中,只是笔者加了个IL模仿学习让联系更加紧密,下面我们来好好解释一下这个范式:

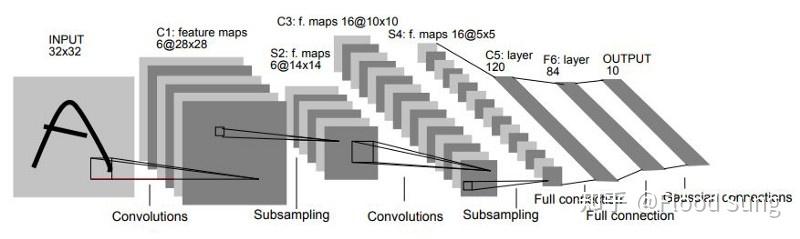

DL主要指的是基于深度神经网络的一套学习训练方式,简单的说就是一个神经网络,一个损失函数,一个反向传播:

LeNet

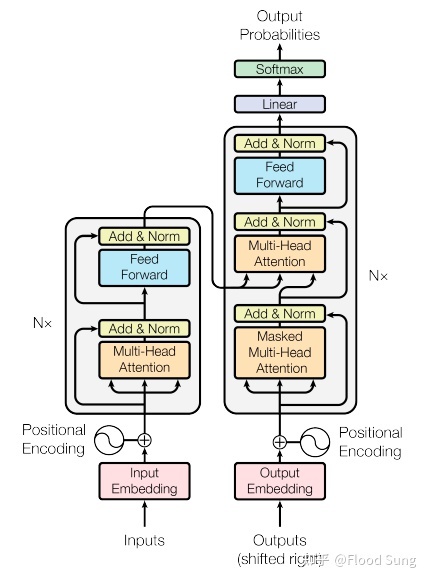

深度学习的发展,网络变了,变成了以Transformer为主流的网络结构,但核心机制是完全没有变化的。

Transformer

IL和RL则是怎么构建损失函数训练这个神经网络的方法。

先说IL 模仿学习,我们可以看到:

AlphaGo的第一代使用大量围棋人类选手的数据来做模仿学习

AlphaStar使用大量星际争霸人类选手的数据来做模仿学习

GPT,ChatGPT呢?也一样,只是改为使用浩瀚的人类文本数据通过自回归autoregressive的方式来做模仿学习。

为什么要模仿学习?因为快啊!模仿学习给神经网络带来的信号强度远远高于强化学习。

那强化学习呢?

当我们不再有足够的可模仿数据的时候,我们只能让AI通过探索的方式来学习,这个时候只有强化学习这条路了:

来自David Silver的ppt

其实我们人类的学习过程不就是模仿学习+强化学习吗?所以,所谓的AI就是模仿人类学习而构建的智能。

所以,我们看到了:

AlphaGo,在模仿学习后开始强化学习,然后水平吊打人类专业选手

AlphaStar,在模仿学习后开始强化学习,然后水平能够战胜人类专业选手

ChatGPT,在模仿学习后(GPT)使用人类反馈的信息做强化学习,然后就能够比较好的按照人类的指令来回答问题了。

这就是强化学习的威力。一定程度上,我们可以认为我们整个人类是一个智能体,正在通过科学家做强化学习来拓展人类的文明边界。

在回答了AGI的范式问题后,我们一定还会问一个问题是:

为什么早几年的AI里程碑都是限定场景,而之后就变成了GPT这样的通用场景?、

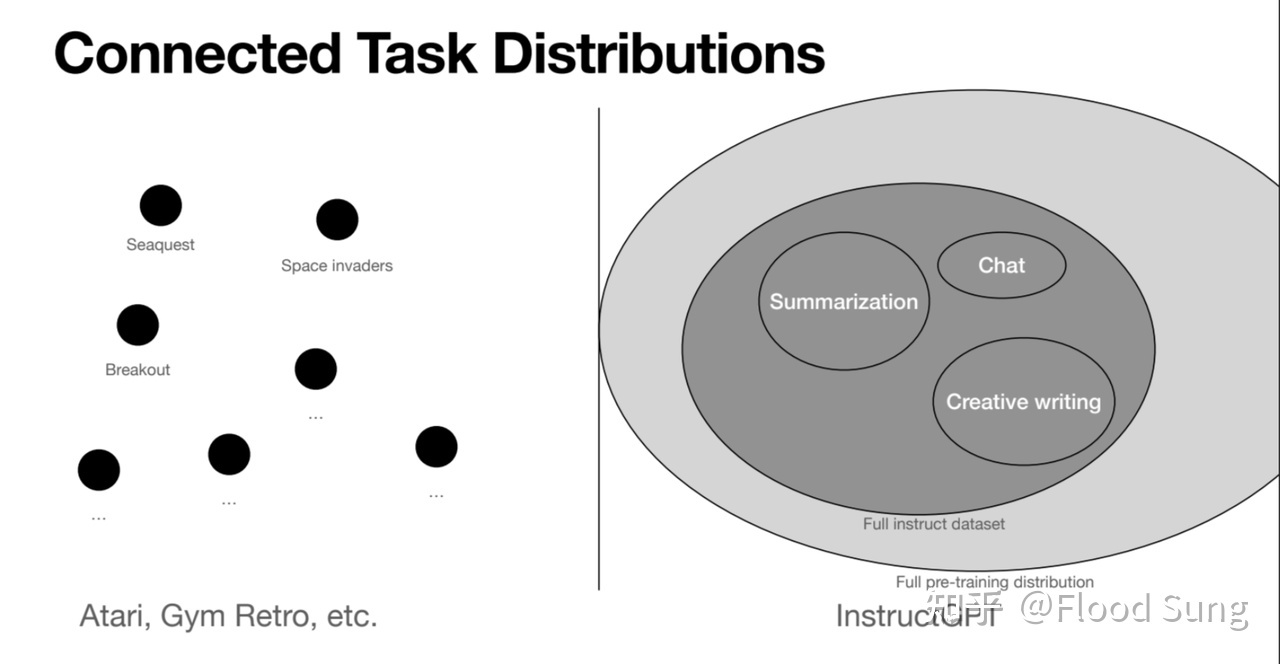

From John Schulman's PPT

因为限定场景的数据量太少,无法实现通用性。上面这个图来自John Schulman (PPO和ChatGPT的作者),它对比了之前Atari等游戏场景及GPT场景在任务分布上的不同。游戏场景都是独立的,不同任务之间的差异也就是Gap非常大,所以AI学会一个游戏并不能让其就会玩另一个游戏。而GPT的场景是文字世界,这个场景里的任务比如总结,写作,聊天都是联系在一起的,所以他们的任务有千千万,并且是连续的,这使得GPT训练完具备了很强的Few-Shot Learning/Meta Learning的能力,即能够实现非常强的泛化能力,面向全新的问题也会回答。

可能一些朋友不了解Meta Learning也就是学会学习,这个概念在学术界2017,2018年后非常火,因为大家发现之前的AI都要大量训练才能做新任务,而人类则具备快速学习能力,由此AI也要具备这样的能力。GPT通过巨量的文本数据做模仿学习,然后InstructGPT通过巨量的任务文本数据做Instruct Finetuning,从而具备了极强的快速学习能力,由此开创了Prompt Engineering或者学术界叫In-Context Learning这个全新领域,即我们不再需要训练模型,只需要修改开头的输入Prompt,就能让AI快速学习并输出合理的结果。

OpenAI快速的捕捉到了文字世界这个场景拥有的数据量无与伦比,因此快速转换了赛道,关掉了机器人组,这种决策让人不得不佩服万分。

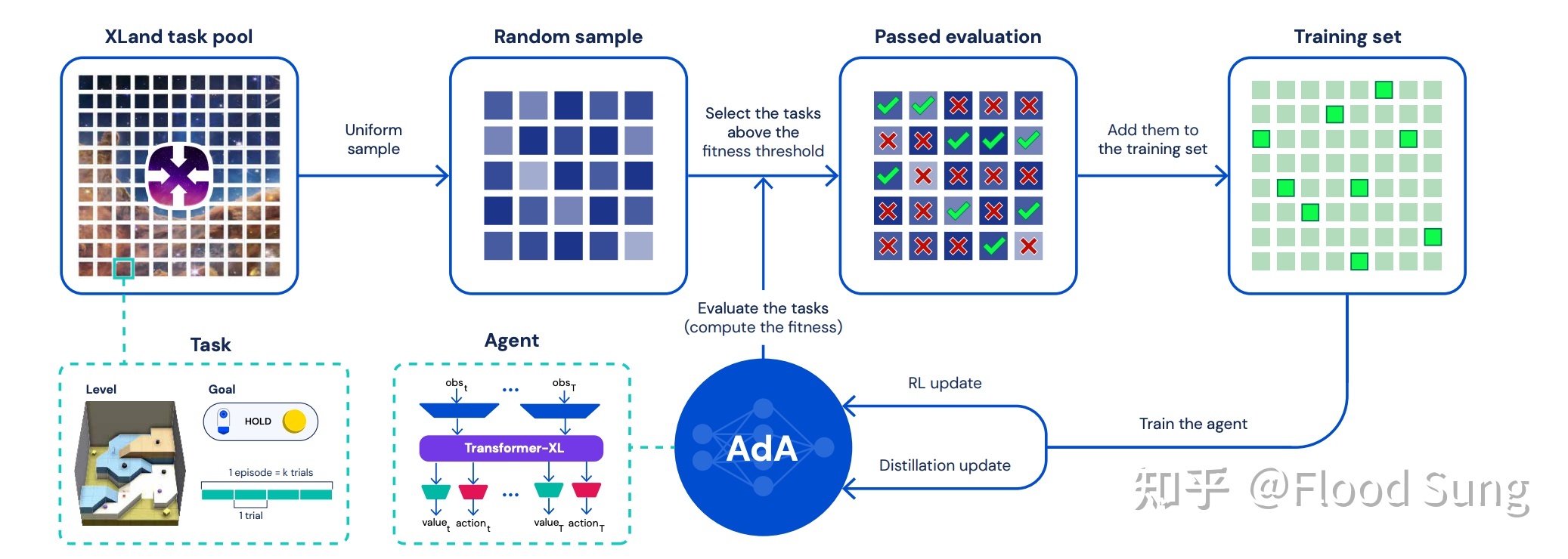

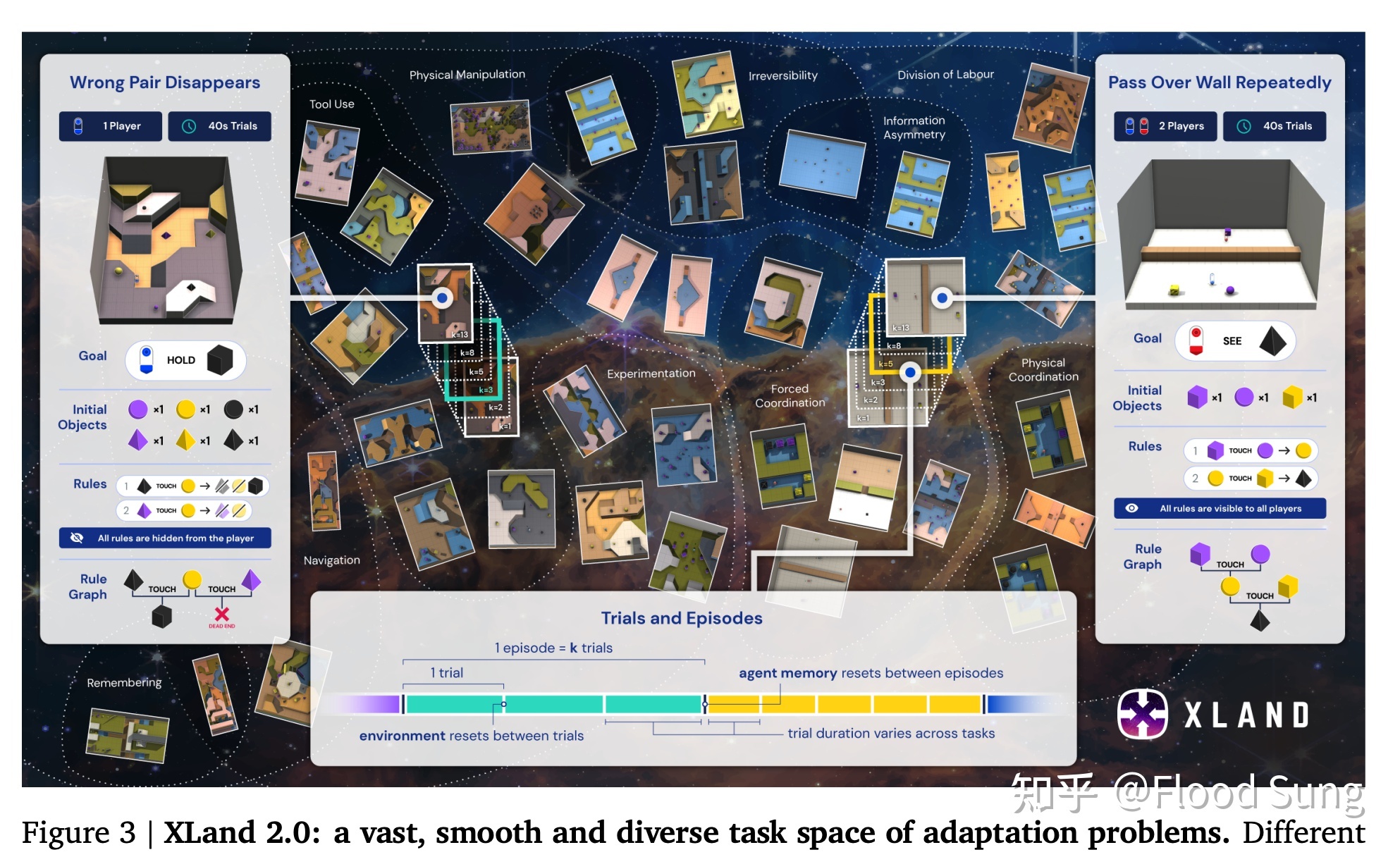

最近,DeepMind发布了Ada,依然是游戏场景里的AI,只是Deepmind也发现了原来Atari的任务空间分布差距太大的问题,改使用自己构建的全新环境Xland进行大模型的训练,该环境具备非常强的任务空间连续性,从而能够在这个游戏场景中产生非常强的智能水平:

从另一个角度看,如果这个XLand未来能够变成真实世界,那么完全体的AGI也就有可能在里面诞生。AGI的实现变成了时间问题。

4 2023-2028: AGI会如何发展?

看完了AGI的历史和现状,我们就能做出一些预测了(我们自己也是个自回归模型啊 )(下文有一些预测出自AI大佬们)

也推荐大家看Jim Fan的预测 https://twitter.com/DrJimFan/status/1616107916662300672

预测1:文字世界的精进,LLM从普通到专业

我们现在看到的ChatGPT看起来是很惊艳,什么都懂点,但细究一下会发现有很多事实错误,逻辑错误。真让它参加下高考,恐怕除了英语,其他都很难考高分。所以,现在的LLM(大语言模型)可以认为是一个什么都懂,但又懂的有点迷糊的普通人。很自然的,下一步的LLM需要变强,变得更专业。 比如,通过高考,能够考出985的水平,这让LLM成为一个真正有知识有文化的人,当然这也意味着AI将完全通过图灵测试!GPT4或许能给我们惊喜!那么通过高考之后,下一步当然是专业领域的学习了。LLM能不能通过司法考试,能不能通过公务员考试?再然后,就是专业领域专家级别的能力了。LLM能不能拿到IMO,ACM的金牌?

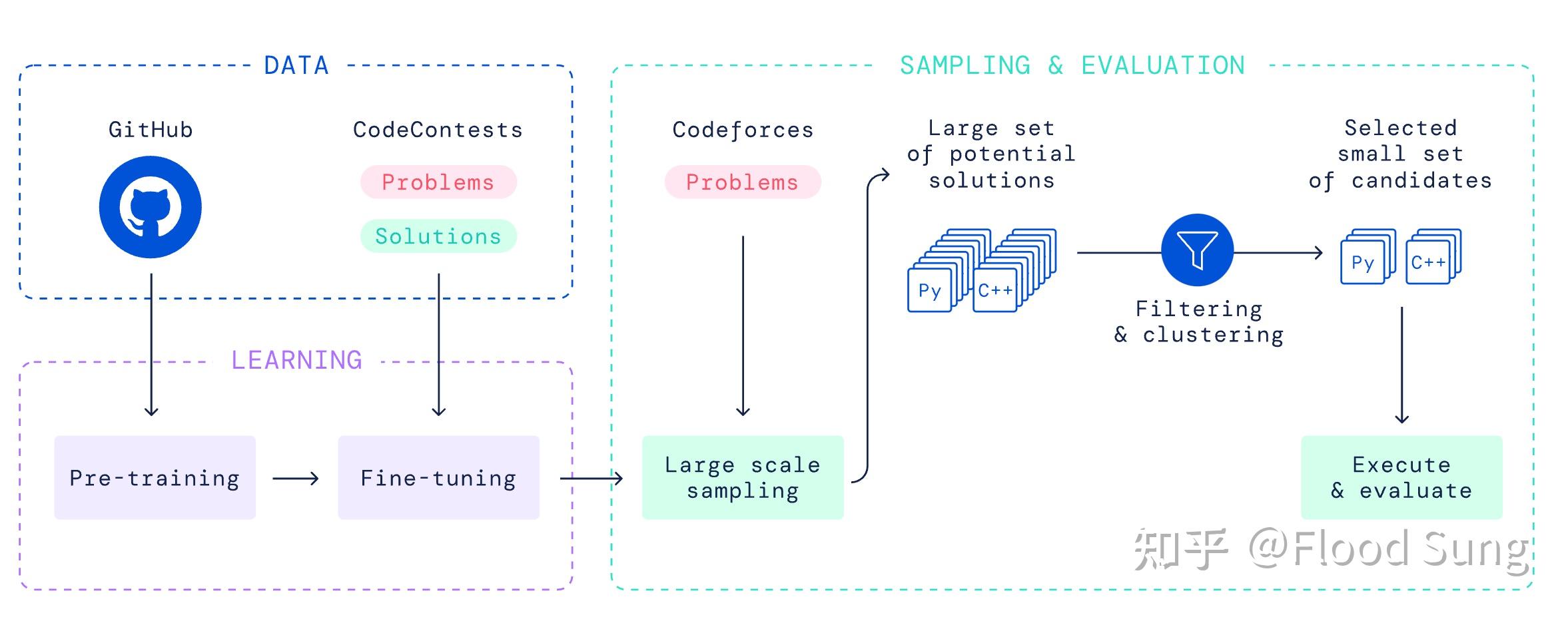

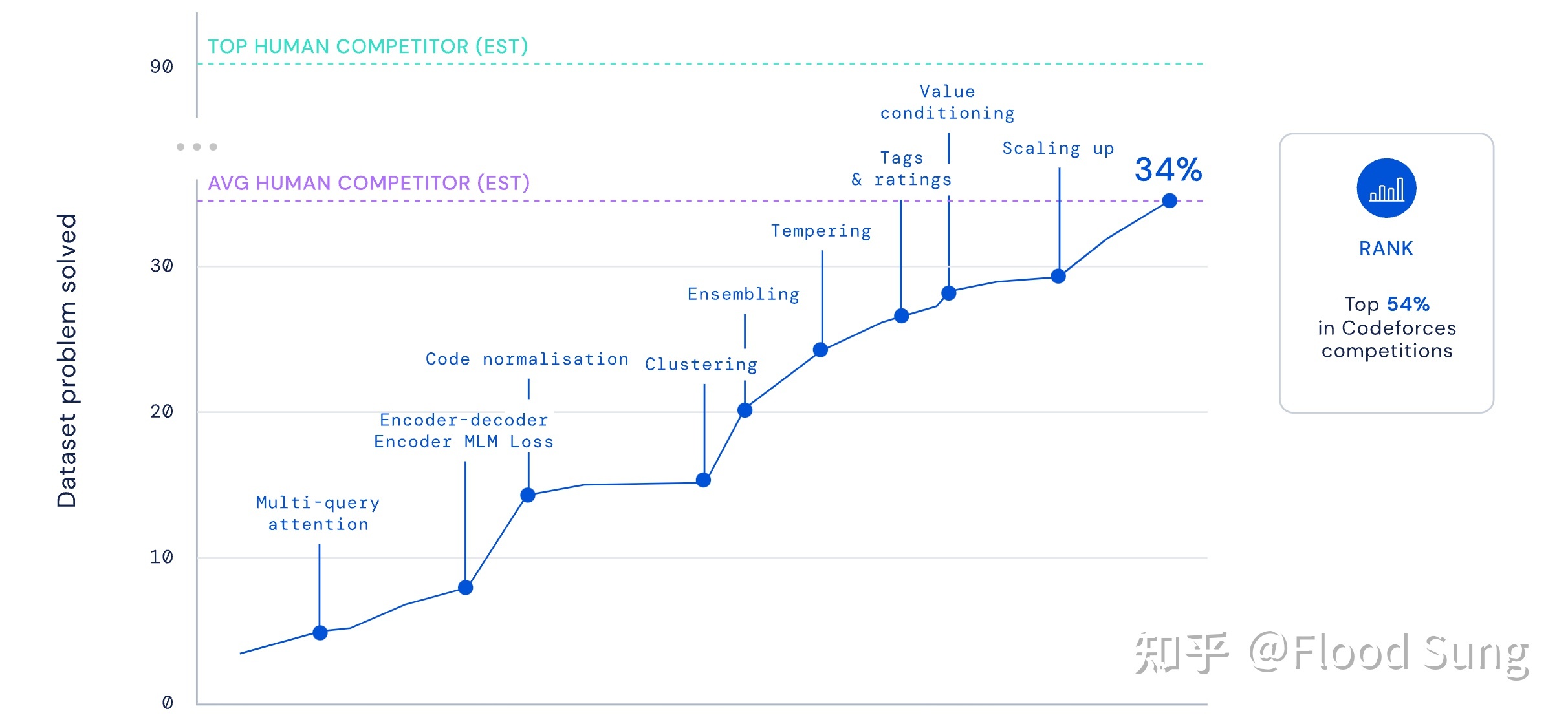

我们前面提到,当模仿学习完之后,需要强化学习来做进一步的精进。这个对于LLM在专业领域同样适用。比如数学,现实世界中就没那么多的数学难题可以模仿,那么要让LLM能解数学难题就得通过强化学习了。这里就带出了一个全新问题,LLM真的可以通过强化学习的训练来做数学难题吗?如果可以,基于Transformer的这套网络架构还可以接着玩下去,如果不行,那么我们就看到了当前LLM的瓶颈了,需要全新的架构才能进一步的突破。这一块或许DeepMind的AlphaCode团队已经在做。我们可以看到AlphaCode目前的算法就是模仿学习:

现在只能做34%的题,排到top 54%:

接下来看通过强化学习,能否干到TOP HUMAN水平。这件事情如果成功,将会是下一个里程碑!

预测2:征服多模态的视频世界

显然,相比文字世界,视频世界的数据量,大了不知道多少个数量级,我们人类从婴儿开始本质上也是通过这种多模态的数据(当然,我们还有触觉,味觉,嗅觉。。)来快速学习。所以,如果AI能够实现很强的多模态学习能力,通过海量的视频进行学习,那么AI将会展现出怎样的能力呢?一定会让人难以置信。据说GPT4是多模态的,期待其发布。这个预测可能毫无信息量,因为所有人都做了这个预测!并且很显然的科学家们就在朝这个方向突破。

预测3:大模型连接现实世界,成为一个General Agent!

我们看到Ada,是在一个非常小的虚拟世界当中,来展现其通用的决策能力。我们又看到,ChatGPT在文字世界中,展现出强大的通用文字能力。AGI不可能局限在文字,也不仅仅是多模态,关键是决策。这也是我们坚信RL是通往AGI的初始原因。因此,大模型会作为一个Agent智能体出现,能够影响现实世界!首先它将面对的现实世界可能是浏览器,电脑,手机,家电,然后就是机器人。

下面是大佬Oriol Vinyals和Andrej Karpathy的tweet截图,大家都看到了这一点。因此,这一块的研究接下来几年会非常有意思。

预测4:自动驾驶将全面转向大模型,并真正向L4,L5进发。

自动驾驶就是一个非常好的限定多模态场景,那么它没有理由不会受益于大模型的发展。一样的范式,用海量数据做模仿学习,然后通过强化学习在仿真环境中做优化,解决掉Corner Case,那么完全自动驾驶没理由不能实现啊。甚至,我们基于一个多模态的大模型在做基础模型,这样,我们获得的不仅仅是自动驾驶能力,而是一个能跟你说话聊天的自动驾驶司机。记得当年的科幻片里的自动驾驶汽车不就是这样嘛。

预测5:通用家用机器人将大幅发展,同样采用大模型

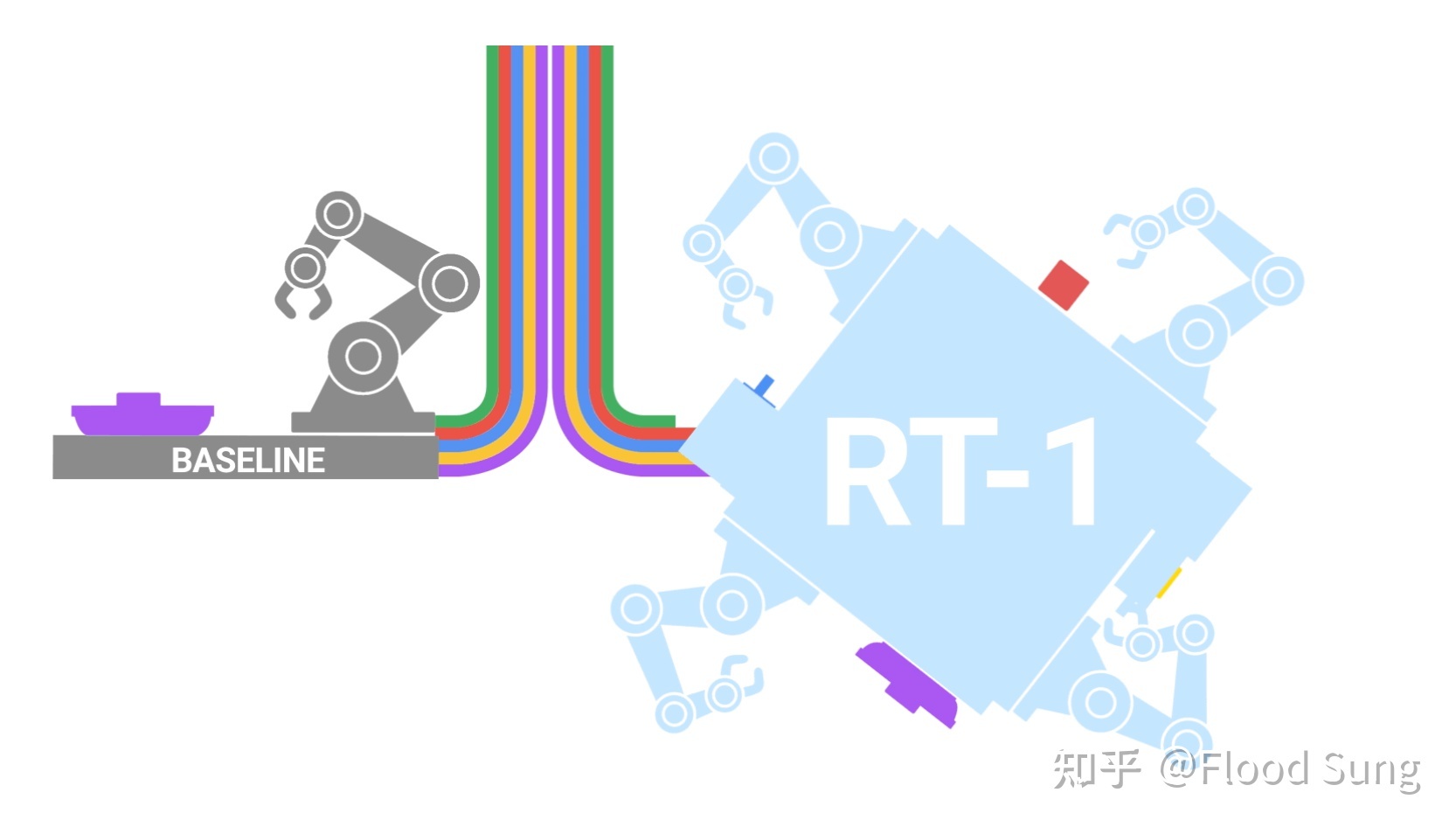

和自动驾驶类似,通用家用机器人也是一个限定的多模态场景,比如只是难度可能更大。Google的RT-1已经验证了大模型驱动机器人的模式是可行的:

接下来的核心还是数据!现实场景最大的问题就是数据,所以OpenAI之前要砍掉机器人部门。那么,如果前面基于视频的多模态学习能很好实现,那么人型机器人就非常好办了,就从人这边学习,看无数的视频,然后映射到人形机器人的动作上。同样的再通过仿真环境做强化学习来解决corner case从而人型机器人将能实现大的突破,走入家庭在10年内不是梦!

预测5:自然语言成为新的编程语言!

同样来自Andrej Karpathy,当然我也是这么想的。如果你玩Prompt玩的足够多,一定也会有这样的想法!所以,现在的小孩还学编程可能意义不大,未来大部分人将直接通过自然语言编程和AI交互。

预测6:AI for Science将突飞猛进,越来越多科学领域被AI突破

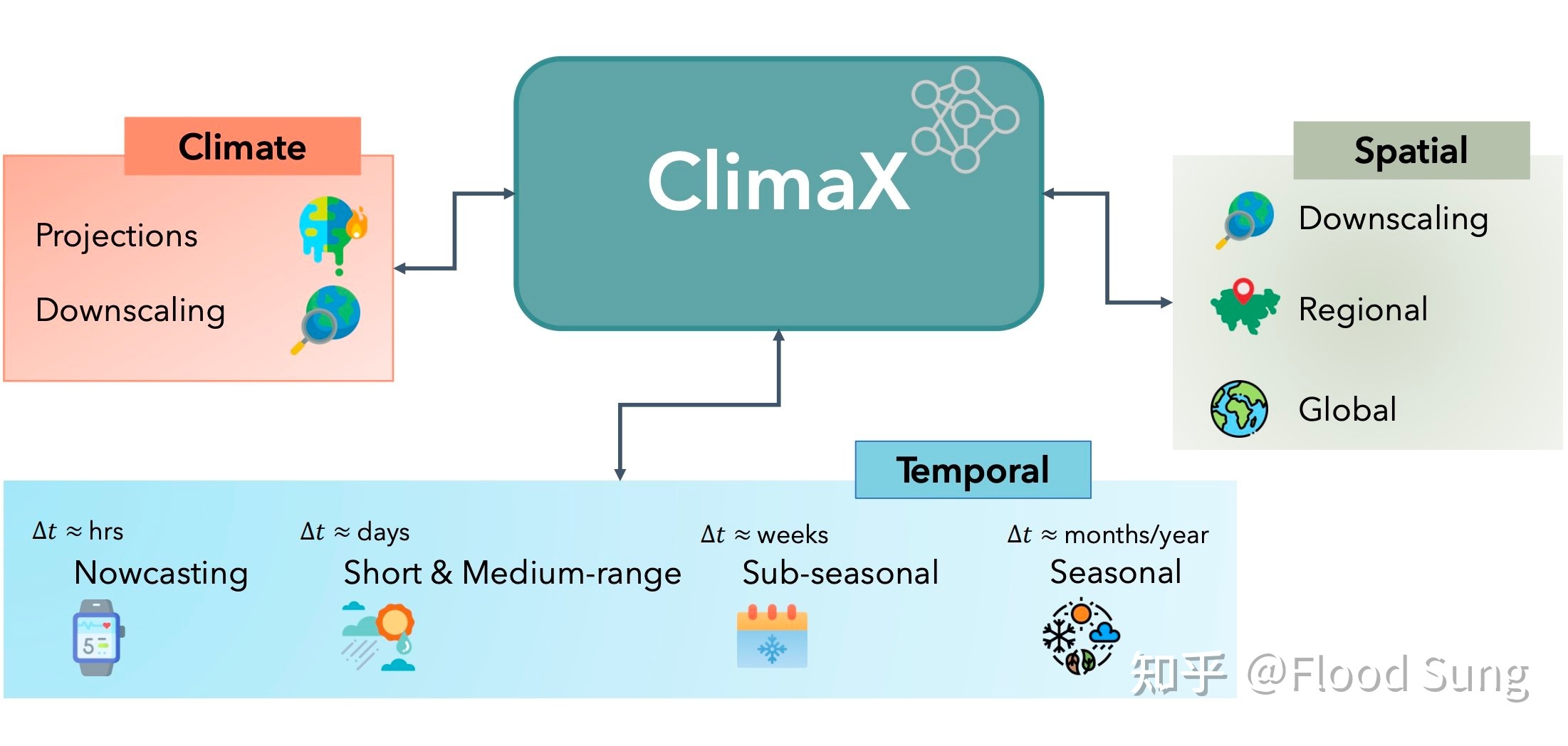

刚看到微软发布的ClimaX,天气预测也是大模型加持。还有什么是大模型不能做的呢?

5 影响:AGI时代,人类将何去何从?

是的,AGI时代在到来,并将颠覆一切。普通人的价值在变小,当AI真的变得无所不能,干什么都比人强的时候,人类存在的意义会被质疑,这一天或许早晚会到来。OpenAI的CEO Sam Altman说到时候就给大家发钱,然后人类就是玩玩玩吗?AI可能不想养这么多人(宠物)了。就如现在,如果利用AI,一个公司本来要5个人,有了AI加持只需要1个人,公司还会雇5个人吗?

终极命题,本文就不详细讨论了。至少在当前,AGI的发展还是太让人兴奋了,相信人类会有美好未来!